Boffins bleat Algoritme pendeteksian Google menunjukkan bias ras

Hentikan kami jika Anda pernah mendengar ini sebelumnya

BAIK BAIK, akankah Anda melihat bahwa algoritma pembelajaran mesin lainnya dari Google yang mengandung bias rasial; siapa yang akan melemparkannya.

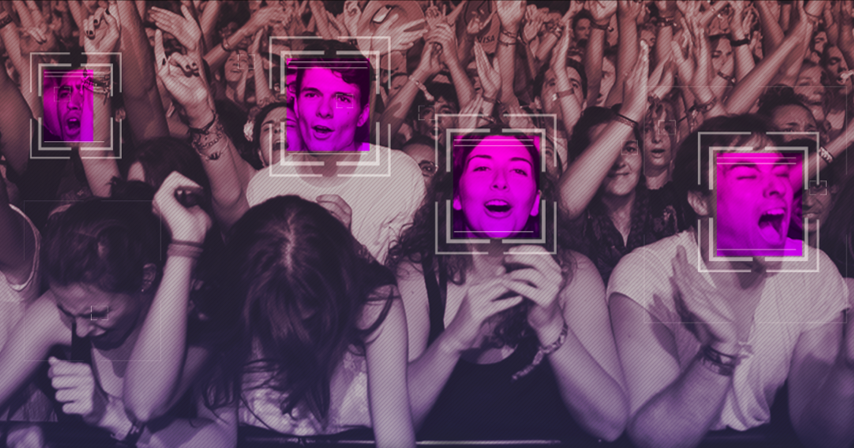

Penelitian yang dilakukan oleh Universitas Washington, Universitas Carnegie Mellon, dan Institut Allen untuk Kecerdasan Buatan sampai pada kesimpulan bahwa alat pengenalan ucapan Perspektif Google, yang merupakan produk dari divisi Jigsaw-nya yang digunakan untuk mendeteksi penyalahgunaan di media sosial, telah menandai slang yang digunakan oleh Orang Amerika kulit hitam lebih toksik daripada mengenali frasa tertentu sebagai bagian dari bahasa mereka.

Orang-orang pintar menerapkan alat Perspektif ke sepasang database yang banyak digunakan dalam deteksi ucapan kebencian, di mana itu akan menetapkan "skor toksisitas" pada posting media sosial yang ditandai sebagai kasar dan ofensif untuk menganggap betapa buruknya tweet tertentu, untuk contoh.

Kejutan, kejutan, ditemukan bahwa alat itu tampaknya memuntahkan skor toksisitas yang lebih tinggi untuk pola bicara orang kulit hitam Amerika.

Masalahnya di sini tampaknya dua kali lipat. Pertama, ada bias dalam database yang digunakan untuk melatih algoritma cerdas seperti kata dan frasa yang dianggap ofensif diberi tag demikian tanpa mempertimbangkan siapa yang mengatakannya dan mengapa.

Sebagai contoh, penggunaan kata 'queer' bisa menyinggung jika digunakan oleh orang heteroseksual sebagai derogatif, namun digunakan oleh orang homoseksual itu bisa menjadi istilah positif; can can apple to N-word yang sama, yang secara ofensif tercela bila digunakan sebagai istilah yang merendahkan oleh orang kulit putih tetapi lebih merupakan bentuk bahasa gaul ketika digunakan oleh orang kulit hitam.

Para peneliti kemudian mencoba alat melawan anotasi mereka sendiri untuk tweet dan menemukan bias yang sama dengan Perspektif. Hanya ketika mereka menambahkan memberi annotator beberapa pengetahuan priming tentang apakah tweet itu ditulis oleh orang kulit hitam atau menggunakan bahasa yang umum dalam bahasa Inggris hitam, tingkat bias berkurang.

Hasil penelitian tidak boleh dilihat sebagai alat untuk merek alat perspektif atau annotator dari database yang dilatih sebagai rasis. Sebaliknya itu menunjukkan bahwa perlu ada upaya ekstra untuk memastikan bias tidak secara tidak sadar terhisap ke dalam sistem dan set data tersebut.

"Kami menemukan bukti kuat bahwa perhatian ekstra harus diberikan pada efek perancu dialek untuk menghindari bias rasial yang tidak diinginkan dalam deteksi ucapan kebencian," kata para peneliti.

Itu mungkin lebih mudah diucapkan daripada dilakukan, karena mendeteksi bias yang tidak disadari adalah hal yang rumit. Tetapi memiliki set data yang lebih beragam dan orang-orang untuk menilai mereka, serta pengembang dari latar belakang yang beragam bisa melakukan beberapa cara untuk menghilangkan bias dari sistem tersebut. μ