Nvidia DGX SuperPod adalah superkomputer GPU Volta 96 × 16 yang baru

Nvidia telah menghadirkan superkomputernya sendiri di ISC High Performance di Frankfurt Main event, yang segera naik ke peringkat 22 dalam daftar peringkat dunia. Yang lebih menarik daripada performanya, bagaimanapun, adalah pendekatan di belakang DGX SuperPOD: Ini menghubungkan 96 DGX-2 yang telah disajikan setahun yang lalu.

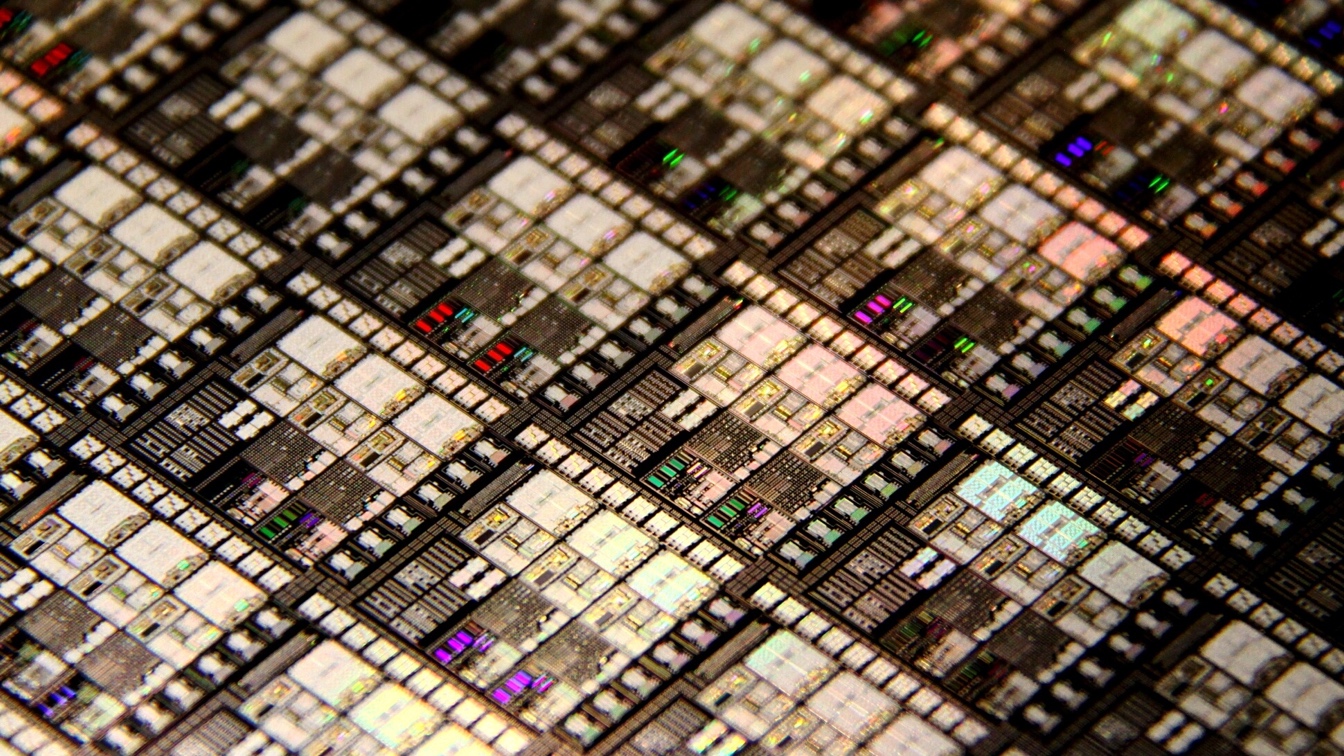

Seperti 96 komponen individualnya, masing-masing diatur ke 16 Volta GPU (Tesla V100 32 GB), sehingga SuperXPX DGX terutama ditujukan untuk perhitungan AI, jelas Nvidia.

Dalam DGX-2, 81.920 shader dari 16 GPU terhubung melalui NVSwitch, yang dengan sendirinya mencakup 2 miliar transistor. Setiap DGX-2 menggunakan Intel Xeon Platinum 8174 dengan 24 core. Untuk penyajian sistem kubus, Nvidia disebut sebagai harga beli sekitar 400.000 dolar AS sebelum pajak. SuperPOD DGX menambahkan hingga hampir $ 40 juta.

Sementara beralih ke arsitektur ARM untuk superkomputer exascale masa depan, kelompok Nvidia menunjukkan fleksibilitas solusi akselerasi GPU untuk kecerdasan buatan dengan mengumumkan kedatangan superkomputer DGX SuperPOD yang kuat.

Dengan kekuatan pemrosesan 9,4 petaflops, ia diposisikan sebagai komputer super terkuat ke-22 di dunia tetapi hanya membutuhkan tiga minggu implementasi, dibandingkan dengan 6 hingga 9 bulan untuk superkomputer dengan arsitektur standar. basis server.

Ini didasarkan pada 96 sistem Nvidia DGX-2H yang masing-masing mengintegrasikan 16 akselerator Nvidia Tesla V100 (yaitu 1536 Tesla V100 untuk seluruh sistem) dan saling terhubung oleh teknologi Mellanox, dengan keunggulan desain modular.

Tujuan utama dari DGX SuperPOD adalah untuk melatih jaringan saraf yang mendalam dari kecerdasan buatan mobil otonom masa depan pasar. Dengan 1TB data yang dihasilkan setiap hari oleh setiap kendaraan dan pelacakan selama beberapa tahun, ini adalah jumlah data raksasa yang perlu diproses dan dianalisis untuk mengurangi potensi kelemahan kecerdasan buatan pada skenario tertentu dan melatih kembali jaringan. neuron untuk membuatnya lebih efisien.

Nvidia mengedepankan kapasitas pemrosesan, dengan contoh pelatihan jaringan saraf ResNet-50 dalam waktu kurang dari 2 menit ketika dibutuhkan 25 hari pada tahun 2015 ketika ditugaskan dengan pemrosesan GPU Nvidia K80.